Künstliche Intelligenz in der Leitungsentscheidung des Vorstands

Der Aufstieg der künstlichen Intelligenz (KI) wird als Revolution gefeiert, die mit der Einführung der Elektrizität vergleichbar ist, die drängendsten Probleme der Menschheit lösen und die Art und Weise, wie wir heute arbeiten, tiefgreifend verändern wird. Zugleich werden ethische Dilemmata deutlich, die den Abbau von Arbeitsplätzen ebenso betreffen wie den Datenschutz, die Gefahr algorithmischer Diskriminierung, die Manipulation der öffentlichen Meinung und die Verschärfung geopolitischer Spannungen durch KI-getriebene Waffensysteme. Fest steht, dass KI in vielen Bereichen die menschliche Leistungsfähigkeit an Schnelligkeit und Präzision übertrifft. Nähert man sich dieser Vorstellung, drängt sich die Frage auf, ob es sich empfiehlt, bestimmte Entscheidungen besser von Maschinen treffen, jedenfalls aber unterstützen zu lassen. Neben Ärzten,1 Rechtsanwälten und Börsenhändlern betrifft das auch Leitungsentscheidungen von Unternehmensführern.2

Für das Aktienrecht liegt darin ein test case, der zur Vergewisserung über die rechtlichen Rahmenbedingungen der Entscheidungsfindung des Vorstands einlädt. Diese mögen den Einsatz von KI im Unternehmen betreffen, etwa in Form von robotics im Produktionsablauf, als large language model im Marketing, der Erstellung von Pressemitteilungen oder der Zusammenfassung von Studien, sowie als machine learning bei der Rekrutierung und Beurteilung von Mitarbeitern. Zusätzlich lässt sich KI im Kontext der originären Leitungsentscheidung des Vorstands einsetzen, etwa bei der Beurteilung von Märkten, der Vorhersage von Risiken oder der Evaluation einer geplanten Strategieentscheidung.

Dabei geht es zunächst um das in § 76 Abs. 1 AktG verankerte aktienrechtliche Delegationsverbot. Je weitergehend eine KI die Vorstandsentscheidung präformiert, desto eher mag man sich fragen, ob es sich noch um eine Leitungsentscheidung in eigener Verantwortung handelt. Neudeutsch formuliert:

Darf man hiervon ausgehen, stellt sich die Anschlussfrage, welche Sorgfaltsanforderungen die § 93 Abs. 1 S. 1, 2 AktG an die Unterstützung von Vorstandsentscheidungen stellen. Erste Stellungnahmen im Schrifttum variieren erheblich. Während manche die Verwendung hochpräziser KI, deren Ergebnisse nicht erklärbar sind (black-box KI), für unzulässig halten,4 verweisen andere darauf, der Vorstand müsse “Herr des Verfahrens”5 bleiben. Hier wird die zuerst genannte Ansicht zurückgewiesen, zugleich aber befürchtet, dass die in der zweiten Meinung unterstellte Trennung zwischen bloßer Vorbereitung und endgültiger Entscheidung mitunter artifiziell werden wird.6 Vorgeschlagen wird ein bewegliches System von Sorgfaltspflichten, abhängig vom sachlichen Gehalt der Entscheidung und der Intensität der durch KI geleisteten Unterstützung.

I. Aktienrechtliche Rahmenbedingungen der Entscheidungsfindung des Vorstands

Kahneman hat Unternehmen als “Fabriken” bezeichnet, die “Urteile (judgments) und Entscheidungen (decisions) herstellen”.7 Das betrifft zunächst einmal alle Hierarchiestufen eines Unternehmens. Für die meisten Beschäftigten ist diese Aufgabe in einen arbeits-, mitunter auch handelsrechtlichen Zusammenhang eingebettet. Eigenständig regelt das Aktienrecht die Entscheidungen des Kollektivs der Vorstandsmitglieder, und zwar in zweierlei Hinsicht. Nur vom Vorstand verlangt das Gesetz in § 76 Abs. 1 AktG die weiter oben als ownership bezeichnete Übernahme von Verantwortung für Leitungsentscheidungen. Ob andere Personen, innerhalb oder außerhalb des Unternehmens, fachkundiger, schneller oder geeigneter für die anstehende Entscheidung wären, ist irrelevant. Damit einher geht ein Vertrauensvorschuss (trust), der in § 93 Abs. 1 S. 2 AktG zum Ausdruck kommt. Jedenfalls bei unternehmerischen Entscheidungen haftet der Vorstand nicht für “simply bad judgment”.8

II. KI und aktienrechtliches Delegationsverbot

Wie verträgt sich die Erwartung des Gesetzes, dass Vorstandsmitglieder Verantwortung übernehmen, mit dem Einsatz einer KI, insbesondere, wenn es sich um eine black-box KI handelt, deren Prognosen nicht erklärbar sind?

1. Vorgaben des § 76 AktG

Was genau § 76 Abs. 1 AktG verlangt, wenn er anordnet, der Vorstand “hat” unter eigener Verantwortung die Gesellschaft zu leiten, entzieht sich bislang einer eindeutigen Bestimmung.9 Konkretisierungsversuche werden in unterschiedliche Richtungen unternommen. Traditionell sondert man originäre Leitungsaufgaben von der bloßen Geschäftsführung ab;10 letztere wird als delegationsfähig eingeschätzt. Zusätzlich trennt man die (unstreitig) delegationsfähige Vorbereitung und Ausführung von der eigentlichen Entscheidung.11 Fest soll hiernach stehen, dass die im Gesetz aufgezählten Pflichtaufgaben, etwa die §§ 83, 90–93, 110 Abs. 1, 118 Abs. 2, 119 Abs. 2, 121 Abs. 1, 131, 161, 170 AktG, vom Vorstand selbst wahrgenommen werden müssen.12 Meist ergänzt eine betriebswirtschaftliche Umschreibung der Kernaufgaben von Managern diese Aufzählung.13 Ebenso unstreitig ist allerdings, dass in bestimmtem Umfang ein vollständiges Outsourcing von Entscheidungen auch an externe Institutionen möglich ist,14 beispielhaft hierfür steht der Betriebsführungsvertrag15 ebenso wie die Auslagerung von Aktivitäten und Prozessen nach § 25b KWG.16 Eine unzulässige Delegation erblickt man hierbei nicht, solange der Vorstand noch eine übergeordnete Steuerungsverantwortung behält und somit “Herr des Verfahrens” bleibt. Diese Stellung soll sich bei der Delegation an Unternehmensmitarbeiter beispielsweise im arbeitsrechtlichen Direktionsrecht, bei der Delegation an externe Dritte in funktional vergleich-

Ob sich aber die einzelnen Elemente einer Vorstandsentscheidung tatsächlich auf diese Weise separieren lassen, ist schon vor der Integration von KI in Vorstandsentscheidungen zu Recht bezweifelt worden. Decision shaping, so ist bei Seibt nachzulesen, “präjudiziert zwingend das decision taking”. Beides sind “Beschreibungen eines einheitlichen Kontinuums des Entscheidungsprozesses und eignen sich daher (. . .) nicht als trennscharfe (. . .) Kategorie”.20

Hinzu kommt, dass sich Vorstandsentscheidungen regelmäßig aus einem ganzen Bündel an Einzelentscheidungen zusammensetzen, die sich wiederum gegenseitig beeinflussen. Delegierbare Elemente lassen sich weder ohne weiteres aussondern noch steht immer fest, wie die Gesamtentscheidung ausgefallen wäre, wenn man einzelne Teilentscheidungen variiert. Dem trägt die “Entweder-oder”-Vorgabe des Gesetzes nicht vollständig Rechnung. Daran knüpfen einige Stimmen in der Literatur ein gelockertes Verständnis des Delegationsverbots, verbunden mit einer Art Auffangfunktion der Vorstandshaftung.21 Diesem Vorschlag wird hier gefolgt, soweit es um eine von der herkömmlichen Dichotomie abweichende Interpretation des § 76 Abs. 1 AktG geht. Die Absonderung eines dem Vorstand vorbehaltenen Entscheidungsteils wird in der Tat häufig artifiziell sein. Vielversprechender erscheint demgegenüber ein graduelles Verständnis der Norm, aufsetzend auf Art und Gewicht unterschiedlicher Elemente der Gesamtentscheidung. Je eher die Gesamtentscheidung eine Verantwortungsübernahme verlangt, also ownership erwartet wird, desto strenger fällt die richterliche Kontrolldichte aus, wenn der Vorstand gleichwohl Kernelemente der Entscheidungsfindung auslagert. Auch der hiesige Vorschlag greift damit absichernd auf § 93 Abs. 1 AktG zurück, allerdings nicht mit Blick auf dessen Haftungsanordnung. Stattdessen wird § 93 Abs. 1 S. 2 AktG die Differenzierung nach unternehmerischen und nicht unternehmerischen Entscheidungen entnommen. Mit diesen geht – ebenfalls

2. Differenzierung nach Art und Gewicht des Einsatzes einer KI bei der Vorbereitung der Vorstandsentscheidung

Nach alledem lässt sich auch die Frage der Zulässigkeit der Verwendung einer KI im Kontext einer Vorstandsentscheidung nur sinnvoll beantworten, indem man Art und Gewicht des individuellen Beitrags bewertet. Mitunter wird die Prognose einer KI nur den Anstoß für eine strategische Entscheidung geben. Ein Beispiel hierfür bildet die KI Alphafold,23 die erschöpfend die Phänomenologie von Proteinfaltungsstrukturen aufgedeckt hat. Ein Vorstand mag das zur Kenntnis nehmen und zu der Entscheidung gelangen, künftig in die Forschung und Entwicklung eines neuen Medikaments zu investieren. Darauf, ob es sich bei Alphafold um eine black-box KI handelt oder nicht, muss es hierbei für den Vorstand nicht ankommen. Seine Entscheidung betrifft insoweit ein known unknown. Möglicherweise wird er sich über die Zuverlässigkeit der Entwickler von Alphafold in Kenntnis setzen. Im Kern handelt es sich aber um eine unternehmerische Entscheidung auf der Grundlage einer eigenen Risikoabwägung des Vorstands. So sind die Kosten zu berücksichtigen, die auf das Unternehmen zukommen, sollten die Alphafold-Prognosen nicht zutreffen. Dem sind die möglichen Gewinnchancen bei Entwicklung eines erfolgreichen Medikaments gegenüberzustellen. Das Delegationsverbot des § 76 Abs. 1 AktG ist dabei von vornherein nicht berührt.

Informiert sich der Vorstand anhand der Abfrage eines large language models oder setzt er ein machine learning Modell ein, etwa um die künftige Marktentwicklung zu prognostizieren, geht der Einsatz der KI über den bloßen Anstoß zu Überlegungen des Vorstands hinaus. Die KI kann dabei eine ganz untergeordnete Informationsfunktion erfüllen, etwa bei der spielerischen Abfrage von ChatGPT. Denkbar ist aber auch, dass die Vorhersage der KI ein zentraler Bezugspunkt des Vorstands ist. Er mag auf dieser Grundlage beispielsweise sein Risikomanagementsystem in großem Umfang automatisieren, weil er davon ausgeht, die KI erkenne relevante Risiken besser als menschliche Mitarbeiter. Ähnlich liegt es, wenn sich der Vorstand für ein neuartiges Produkt entscheidet oder sein Engagement auf einen bislang nicht bearbeiteten Markt ausdehnt, weil er sich auf die Prognose der KI verlässt. Auf der Hand liegt, dass das taking einer Entscheidung nach wie vor durch den Vorstand erfolgt. Steuert die KI nur ein untergeordnet informierendes Element bei, verändert sich hierdurch der Charakter der Vorstandsentscheidung nicht. Ebenso deutlich ist aber, dass die Integration von KI in eine Vorstandsentscheidung

Inwieweit in zunehmendem Maße Entscheidungsverantwortung an Maschinen abgegeben wird, wirft interessante verhaltenspsychologische und entscheidungstheoretische Fragen auf. Für die Beurteilung, ob das Delegationsverbot des § 76 Abs. 1 AktG verletzt ist, sollten diese allerdings nicht entscheidend sein. An ownership im aktienrechtlichen Sinn dürfte es dem Vorstand nämlich nur in dem weitgehend theoretischen Fall fehlen, dass er sich der eigenen Entscheidungsmacht vollständig begibt,25 etwa wenn die Geschäftsordnung vorsehen sollte, dass der Vorstand gleichsam ausführendes Organ einer KI wird. Folgt man dieser engen Interpretation, haben die Bedenken, die insbesondere Dubovitskaya und Buchholz gegenüber der Verwendung nicht erklärbarer KI angemeldet haben,26 nicht das Delegationsverbot im Auge. Stattdessen betreffen diese aktienrechtliche Sorgfaltspflichten des Vorstands mit Blick auf die Vorbereitung einer Vorstandsentscheidung. Darum soll es im nächsten Abschnitt gehen.

III. KI und aktienrechtliche Sorgfaltspflichten bei der Vorbereitung von Vorstandsentscheidungen

Weiter oben wurden die beiden Eckpfeiler der Erwartungshaltung des AktG gegenüber Vorstandsentscheidungen als ultimative Entscheidungsherrschaft (ownership), kombiniert mit einer Vertrauensinvestition der Aktionäre (trust), beschrieben. Die fachkundige Vorbereitung von Leitungsentscheidungen kann durch technische Unterstützung geschehen, die traditionell vom Taschenrechner bis hin zum komplexen Rechnernetzwerk reicht. Hilfestellung bieten außerdem Unternehmensmitarbeiter und, wie etwa die §§ 25b KWG, 32 VAG belegen, externe Quellen.

1. Wenig konkrete Sorgfaltspflichtvorgaben des AktG mit Blick auf die Vorbereitung der Vorstandsentscheidung

Auf die Frage, auf welche Weise vom Vorstand Vorbereitung und Unterstützung seiner Entscheidungsfindung einzufordern und die erhaltene Information zu evaluieren ist, gibt sich das AktG allerdings einsilbig. Für die Auswahl der zu Rate gezogenen Quelle und den Umgang mit deren input gilt einheitlich der Sorgfaltsmaßstab des § 93 Abs. 1 S. 1 AktG. Anders als etwa das US-amerikanische Recht sieht das AktG weder eine Binnendifferenzierung nach der ausgewählten Unterstützung27 noch eine Kongruenz zwischen der Intensität der geforderten Überprüfung und der Art der Entscheidung oder beweisrechtliche Erleichterungen, beispielsweise mit Blick auf die Informationsversorgung bei unternehmerischen Entscheidungen, vor.28

Von der Notwendigkeit mindestens fallweiser Konkretisierung des allgemeinen Sorgfaltsmaßstabs enthebt die gesetzgeberische Schmallippigkeit nicht. Sie ist unter dem AktG Rechtsprechung und Literatur überlassen. Beispielhaft hierfür steht die Ision-Entscheidung des BGH, welche für einen Vorstand, der Rechtsberatung erhält, den allgemeinen Sorgfaltsmaßstab durch eine Plausibilisierungsobliegenheit verschärft. Neben der Auswahl eines geeigneten Beraters ist dieser auch angehalten, eine erhaltene Information inhaltlich zu bewerten. Zur Illustration einer anderen Fallgruppe dienen die Überlegungen von Dreher, der Pflichten danach differenziert, ob vertikale, horizontale oder externe Hilfe nachgefragt wird.29 Noch einen anderen Aspekt der Kontrolle von Vorstandsentscheidungen betrifft die Frage der Breite und Tiefe der Informationsbeschaffungspflicht bei unternehmerischen Entscheidungen. Auf einen einheitlichen Maßstab konnten sich Rechtsprechung und Literatur insoweit noch nicht einigen. Die Rechtsprechung neigt zu einer eher intensiven Kontrolle der Informationsbasis, auf deren Grundlage der Vorstand eine unternehmerische Entscheidung trifft.30 Zahlreiche Stimmen in der Literatur verweisen demgegenüber auf den historischen Gesetzgeber, dem daran gelegen war, die nachträgliche richterliche Kontrolle zurückzudrängen. Insbesondere die unter Zeitdruck auf limitierter Informationsbasis getroffene

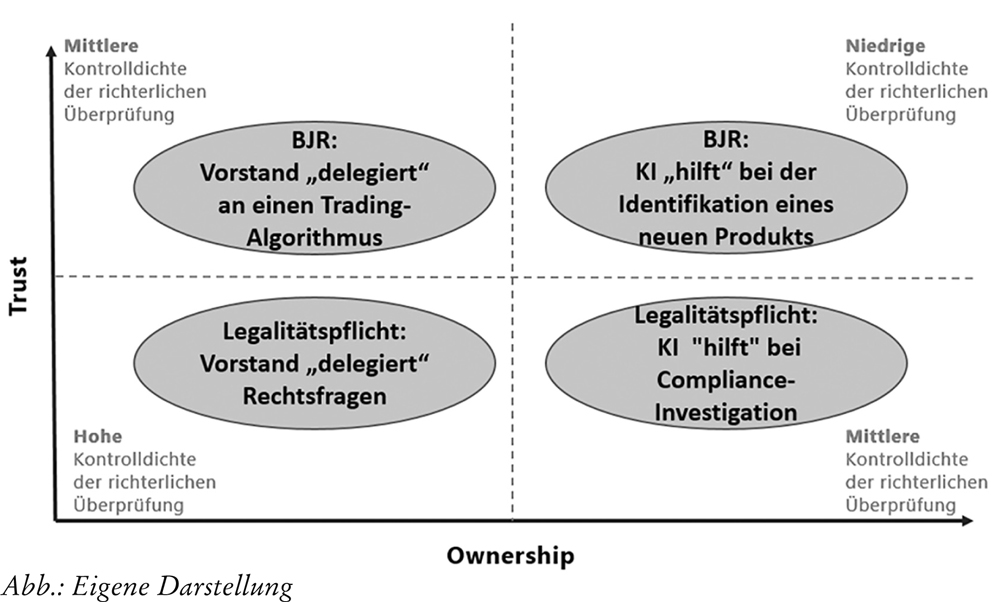

2. Kontrollmatrix für die Beurteilung einzelner Elemente der Vorstands- entscheidung

Versucht man, das aus Fällen und Einzelfragen entstandene Mosaik zu ordnen und mit den Vorgaben des § 76 Abs. 1 AktG zu kombinieren, entsteht in Umrissen eine Kontrollmatrix entlang derer sich die richterliche Überprüfungsdichte einer Vorstandsentscheidung beurteilen lässt. An die Stelle der “Entweder-oder”-Dichotomie tritt dabei die graduelle Verortung einer Entscheidung.33 Auf der y-Achse mag man sich die Freiheit vorstellen, welche Gesetz und Aktionäre dem Vorstand bei der Vornahme seiner Entscheidung einräumen (trust). Unternehmerische Entscheidungen rangieren ganz oben, soweit § 93 Abs. 1 S. 2 AktG einen breiten Entscheidungsspielraum eröffnet. Fehlt bei einem Vorstandsbeschluss hingegen jedes unternehmerische Element, befindet es sich auf der y-Achse ganz unten. Auf der x-Achse lässt sich abtragen, inwieweit der Vorstand seine Entscheidung eigenständig oder auf fremder Hilfe gründend trifft (ownership). Belässt er es bei traditionellen technischen Hilfsmitteln, erzielt er hohe Werte. Im Mittelfeld befindet sich die Befragung von Unternehmensmitarbeitern. Niedrige Werte auf der ownership-Achse erhält eine Vorstandsentscheidung, bei welcher nur nachvollzogen wird, was externe Berater vorgegeben haben.

Ision fällt bei dieser Matrix beispielsweise in das linke untere Feld, soweit es um die Legalität der vorgenommenen Kapitalerhöhung (und damit den Streitgegenstand) geht. Entscheidungen über Rechtsfragen sind keine unternehmerischen Entscheidungen, erzielen also niedrige Werte auf der trust-Achse. Der Nachvollzug von Rechtsrat außerhalb des Unternehmens verortet den Fall

Der oben beschriebene Alphafold-Fall befindet sich hingegen im oberen rechten Feld der Matrix. Die Investition in die Entwicklung eines neuen Medikaments ist eine unternehmerische Entscheidung, der Vorstand erhält einen breiten Ermessensspielraum. Die getroffene Entscheidung beruht auf der vom Vorstand eigenverantwortlich vorgenommenen Risikoabwägung, insbesondere wurde die KI nicht als Experte zur Beurteilung einer Vorstandsstrategie herangezogen, sondern gab nur den Anstoß zur Entscheidung. Die richterliche Kontrolldichte ist deshalb gering.34

3. Einordnung von KI-Unterstützung in die Kontrollmatrix

Folgt man dem Vorschlag, die Kontrolldichte einer Vorstandsentscheidung nach Art und Gewicht ihrer unterschiedlichen Elemente zu variieren, erlaubt die skizzierte Matrix die graphische Verortung einer Entscheidung, um die Intensität ihrer richterlichen Überprüfung abzulesen. Der Einsatz einer KI ist vor diesem Hintergrund entlang der x-Achse abzutragen. Je intensiver die KI die Entscheidung des Vorstands prägt, desto niedriger der ownership-Wert.

Das rechte obere Feld, in welchem sich eigenständig getroffene unternehmerische Entscheidungen befinden, ist mit der geringsten richterlichen Kontrolle konfrontiert. Das Beispiel der KI Alphafold, die nur als Anstoß wirkte, illustriert das. Die Investitionsentscheidung des Vorstands, ein neues Medikament zu entwickeln, unterscheidet sich in der Sache nicht von anderen Investitionsentscheidungen, bei denen eine KI keine Rolle gespielt hat. Das Risiko einer Fehlentscheidung der KI stellt ein fest umrissenes und identifizierbares known unknown dar, welches sich bepreisen lässt.

In das linke obere Feld gehören unternehmerische Entscheidungen, die mit intensiver Hilfe von außen getroffen werden. Man stelle sich etwa den Einsatz einer KI im Bereich des algorithmic trading und einen Vorstand vor, der sich aus der eigenen Überwachung und Steuerung zurückzieht. Lässt man bankaufsichtsrechtliche Vorgaben beiseite35 und konzentriert sich auf das business judgment-Element, bildet das Risiko einer Fehlentscheidung der KI erneut ein known unknown. Dessen Bepreisung ist allerdings viel schwieriger. Anders als bei Alphafold geht es nicht um einen fest umrissenen Baustein der Entscheidung, sondern in der Sache um den Rückzug des Vorstands aus der Übernahme von Eigenverantwortung, indem er der KI freie Hand lässt. Obwohl unternehmerische Entscheidungen getroffen werden, ist die Kontrolldichte aus diesem Grund höher als im voranstehenden Beispiel.

Im rechten unteren Feld finden sich Entscheidungen, die nicht unter § 93 Abs. 1 S. 2 AktG fallen, aber vom Vorstand eigenständig und ohne Heranziehung fremder Hilfe verantwortet werden. Steuert eine KI in diesem Kontext einzelne Informationselemente bei, gelten die etablierten Sorgfaltsanforderungen des § 93 Abs. 1 S. 1 AktG. Zur Illustration mag man sich eine KI vorstellen, die einen Beitrag zu einem Compliance Management System erbringt, indem sie unternehmensinterne E-Mails nach bestimmten Mustern untersucht.36 Weil die Einhaltung rechtlicher Vorgaben, etwa des § 25c Abs. 4a Nr. 3 lit. c) KWG,37 in Rede stehen kann, ist die richterliche Kontrolldichte intensiver als bei den ersten beiden Beispielen aus den oberen Feldern der Kontrollmatrix. Immerhin bleibt aber das ownership-Element des Vorstands hoch, wenn die KI-Abfrage nicht den Kern des Compliance Management Systems bildet, sondern nur einen ersten Anstoß, der bei Auffälligkeiten zu einer weiteren, vom Vorstand verantworteten Untersuchung führt.

Noch intensiver wird die Kontrolldichte, wenn man dieses Beispiel variiert. Man stelle sich den Einsatz einer KI im Risikomanagement einer Bank vor, die – anders als das beschriebene Compliance System – den Gutteil der Prüfung vollständig der KI überantwortet. Je umfänglicher das geschieht, desto weiter bewegt sich dieser Fall in das linke, untere Feld. Die Vorhaltung und Durchführung einer Risikomessung ist keine unternehmerische Entscheidung, sondern von § 25a KWG zwingend vorgegeben, die richterliche Kontrolldichte schon aus diesem Grund hoch. Das verstärkt sich noch, wenn der Vorstand – anders als im Compliance Beispiel – nicht eigenverantwortlich entscheidet, sondern den Vorschlag der KI nur nachvollzieht. Je eher man hiervon ausgehen muss, desto deutlicher fällt die Nähe zur Ision-Entscheidung aus, bei der von außen gelieferte Informationen einen zentralen Baustein der Vorstandsentscheidung bildeten. Einschlägig ist für dieses Feld folglich die höchste richterliche Kontrolldichte, die Ision als nachgelagerte Plausibilitätsprüfung gefasst hat.

Diese Überlegungen lassen sich wie folgt visualisieren:

a) KI und Plausibilitätsprüfung

Vor diesem Hintergrund gilt: Je umfangreicher der Beitrag einer KI zur Vorstandsentscheidung ausfällt und je geringer der Anteil von business judgment-Elementen im Kontext der Gesamtentscheidung, desto engmaschiger die richterliche Kontrolldichte. Damit ist allerdings noch nicht gesagt, wie diese Kontrolle auszusehen hat. Erste Stimmen in der Literatur halten an der Plausibilitätsprüfung auch für den Einsatz einer KI fest,38 andere lehnen das ab, insbesondere wenn eine black-box KI in Rede steht.39

Trennt man den Grund für die Einführung der Plausibilitätsprüfung von deren Methode, zeigt sich, dass beide Ansichten wichtige Aspekte hervorheben. Ision werden für gewöhnlich vor allem zwei Überlegungen entnommen: Zum einen darf die Heranziehung eines Experten die von § 76 Abs. 1 AktG verlangte Übernahme von Eigenverantwortung nicht unzuträglich einschränken; zum anderen ist auch bei der externen Beratung des Vorstands auf Interessenkonflikte zu achten. Beide Gesichtspunkte sind für die Heranziehung einer KI durch den Vorstand einschlägig. Für die zuletzt genannten Interessenkonflikte liegt das auf der Hand. Die Auswahl eines bestimmten KI-Modells, sorgfältig zugeschnittener Daten (trimming) oder Abfragetechniken, um das gewünschte Ergebnis zu produzieren, ist ebenso unzulässig wie ein opinion

Wendet man sich allerdings der in Ision gewählten Methode der Plausibilitätsprüfung zu, insbesondere der kritischen Nachfrage und dem Abgleich mit Erfahrungswissen, wird deutlich, dass für die Übertragung auf eine KI-Prüfung Anpassungen erforderlich sind. Für die Zwecke dieses Editorials soll gleichwohl am Begriff der Plausibilitätsprüfung festgehalten werden.42

b) Zur Methode der KI-Plausibilitätsprüfung

Dubovitskaya und Buchholz betonen eindringlich, dass die Nachprüfung einer KI-Prognose, insbesondere wenn es sich um eine black-box KI handelt, durch Menschen nicht geleistet werden kann und knüpfen hieran die Unzulässigkeit der Verwendung eines solchen Modells.43 Dabei wird übersehen, dass es auch bei Ision nicht darum geht, das eingeholte Rechtsgutachten in der Sache zu evaluieren. Der Grund für die externe Unterstützung liegt ja gerade darin, dass dem Vorstand das erforderliche Fachwissen fehlt. Gefordert ist vielmehr der Abgleich des vom Experten erzielten Ergebnisses mit Marktwissen, Erfahrung und Intuition der Vorstandsmitglieder – judgment in der Terminologie von Kahneman. Die Unzulässigkeit der für die Kapitalerhöhung gewählten Struktur, so der BGH, hätte dem Vorstand vor diesem Hintergrund auffallen müssen. Anders formuliert: Der Vorstand soll nicht der bessere Jurist, sondern der erfahrene Manager mit kritischem Blick (auch) auf Fachgutachten sein.44

Versteht man den Kern der Ision’schen Plausibilitätsprüfung in diesem erfahrungsgesättigten, kritischen Blick, zeigt sich, dass hierfür auch mit Blick auf die Integration einer KI in Vorstandsentscheidungen breiter Raum besteht. Anders als in der Ision-Situation, die menschliche Experten betrifft, ist diese Prüfung allerdings an die Interaktion mit einer Maschine anzupassen. Dem Störgefühl, dass “etwas nicht stimmt” oder “das irgendwie nicht passt”, lässt sich nicht auf dieselbe Weise durch Nachfrage und Erörterung unter Men-

Die dogmatische Ausformung der für die technische Produktkontrolle einer KI geltenden Sorgfaltspflichten unterscheidet sich zunächst einmal nicht fundamental von etablierten Pflichten mit Blick auf herkömmliche Maschinen. Gesetzliche und untergesetzliche Normen sind einzuhalten, das gilt insbesondere für die im Entstehen begriffene KI-Verordnung der EU.47 Zertifizierungen sind zu berücksichtigen, ebenso Marktstandards. Für die Auswahl einer geeigneten KI wird im Regelfall Beratung erforderlich sein. Ihr Betrieb verlangt eine laufende Kontrolle, Fehlersuche und eventuell eine Reaktion.

Wesentlich komplexer stellt sich die kognitive Kooperation mit einer KI dar. Sie setzt voraus, dass sich der Vorstand darüber in Kenntnis setzt, wie die KI “denkt”.48 Eine zentrale Rolle nehmen hierbei die verwendeten Daten und deren Rolle in der Prognose der KI ein. Diese beruht bekanntlich auf einer Wahrscheinlichkeitsberechnung und damit unter anderem auf einem Vergleich der vorgelegten Situation mit ähnlichen Vorkommnissen im Datenbestand der KI.49 Einen potentiellen Kreditnehmer bewertet eine KI umso besser, je eher er Attribute aufweist, die in der Vergangenheit Kreditnehmer mit einem geringen Ausfallrisiko kennzeichneten.50 Bewerber auf eine ausgeschriebene Stelle sortiert die KI anhand von Kriterien und Mustern, die sie

Mit der zentralen Rolle, die Daten bei derartigen Vorhersagen zukommt,52 hängt die Prüfungsrolle des von der KI beratenen Vorstands zusammen.53 Die auf der Basis historischer Daten errechnete Prognose kann schon deshalb ungeeignet sein, weil sie eine fundamentale Veränderung nicht hinreichend berücksichtigt, oft zitierte Beispiele sind die Finanzkrise oder die Pandemie, die derzeit die Weltöffentlichkeit beherrschenden Kriege kommen hinzu. Mitunter wird Datenmaterial auch im Großen und Ganzen nützliche Vorhersagen ermöglichen, die aber gerade für den vom Unternehmen intendierten Zweck, der eine Marktnische betreffen mag, ungeeignet sind. Zu unzutreffenden Prognosen können auch unpräzise Daten führen, etwa wenn auf nicht überprüfte Inhalte sozialer Medien zugegriffen wird – das viel zitierte “garbage in, garbage out” verdeutlicht das. In all diesen Beispielen wird deutlich, dass dem Vorstand nicht die Widerlegung von Rechenvorgängen der KI angesonnen wird, sondern die Nachverfolgung eines aus Marktkenntnis, Erfahrung und Intuition entstandenen Störgefühls. Die Analogie zur kritischen Nachfrage bei einem Ision-Experten liegt dann in dieser Auseinandersetzung mit der KI, insbesondere mit dem verwendeten Datenmaterial.

c) KI und Erklärbarkeit

Im Verlauf des Beitrags wurde bereits deutlich, dass die Erklärbarkeit einer KI-Prognose keine notwendige Voraussetzung für deren Verwertung im Kontext einer Vorstandsentscheidung ist. Soweit die KI-generierte Vorhersage nur ein Element der Vorstandsentscheidung bildet und das Risiko einer Fehlprognose als known unknown behandelt werden kann, liegt das auf der Hand.54 Erklärbarkeit spielt in diesem Fall nur dann eine Rolle, wenn sich das Risiko auf diese Weise signifikant mindern lässt.55

Anders kann zu entscheiden sein, wenn es für die Beachtung einer Rechtsnorm gerade darauf ankommt, dass der Entstehungsprozess der KI-Prognose reproduziert werden kann. Das weiter oben erwähnte bankaufsichtsrechtliche Risikomanagement ist ein Beispiel hierfür.56 Auch für die Frage, ob eine unzulässige Diskriminierung vorliegt, kann die Erklärbarkeit einzelner Prozesse erforderlich werden. So wird man dem Vorstand einer Bank nicht zugestehen, Kreditentscheidungen ausschließlich auf der Basis eines black-box KI-Vorschlags treffen zu lassen, wenn das entstehende Kreditportfolio mittelbar diskriminierend wirkt.57

IV. Ausblick

Die Entwicklung eines aktienrechtlichen Rahmens für den Umgang des Vorstands mit KI-unterstützten Leitungsentscheidungen steht noch ganz am Anfang. Ein besonderes Augenmerk wird dabei auf die Konkretisierung des Delegationsverbots des § 76 Abs. 1 AktG und der sehr allgemein gefassten Sorgfaltspflicht des § 93 Abs. 1 S. 1 AktG zu legen sein. Dieser Beitrag steuert eine Kontrollmatrix bei, welche die Intensität richterlicher Kontrolldichte

Katja Langenbucher

| 1 | Hierzu die Monographie zum schweizerischen Recht von Batache, Künstliche Intelligenz in der Medizin aus haftungsrechtlicher Perspektive (im Erscheinen). |

| 2 | Langenbucher, SAFE White Paper No. 96/2023, S. 1, abrufbar unter https://safe-frankfurt.de/de/publikationen/details/publicationname/ki-in-der-leitungsentscheidung-des-vorstands-der-aktiengesellschaft.html. |

| 3 | Zur Abgrenzung der Aufgaben des Vorstands von den Kompetenzen anderer Organe Cahn, NZG 2023, 300; Koch, FS 50 Jahre AktG, 2016, S. 65, 67 f., 77 ff. |

| 4 | Dubovitskaya/Buchholz, ZIP 2023, 63. |

| 5 | Möslein, ZIP 2018, 204, 208; ders., Der Aufsichtsrat 2020, 2, 3. |

| 6 | Andeutungen bei Noack, ZHR 183 (2019) 105, 120 f. |

| 7 | Im Original: “factories that manufacture judgments and decisions”, Kahneman, Thinking, Fast and Slow, 2011, S. 417. |

| 8 | Joy v. North 692 F2.d 880, 885 (2d Cir.), cert. denied, 460 U.S. 1051 (1983); Bainbridge, Corporate Law, 2020, S. 125; ebenso BGH v. 21. 4. 1997 – II ZR 175/95, BGHZ 135, 244, 253; BGH v. 21. 12. 2005 – 3 StR 470/04, NJW 2006, 522, 523. |

| 9 | BeckOGK/Fleischer, Stand: 1. 10. 2022, § 76 AktG Rdn. 10: “Pflichtrecht”; Grigoleit/ders., AktG. 2. Aufl. 2020, § 76 AktG Rdn. 10; Koch, FS 50 Jahre AktG, 2016, S. 65, 94 ff.; MünchKommAktG/Spindler, 6. Aufl. 2023, § 76 AktG Rdn. 31; eingehend Dreher, FS Hopt, 2010, S. 517. |

| 10 | Emde, FS Schneider, 2011, S. 295, 299; Fleischer, ZIP 2003, 1, 3; kritisch Seibt, FS Karsten Schmidt, 2009, S. 1463, 1464. |

| 11 | Dreher, FS Hopt, 2010, S. 517, 527; Fleischer, ZIP 2003, 1, 3, 7; Grigoleit/ders. (Fn. 9), § 76 AktG Rdn. 10. |

| 12 | Dreher, FS Hopt, 2010, S. 517, 520 f.; Fleischer, ZIP 2003, 1, 6; Seibt, FS Karsten Schmidt, 2009, S. 1463, 1470 f. |

| 13 | Fleischer, ZIP 2003, 1, 5; Seibt, FS Karsten Schmidt, 2009, S. 1463, 1471; krit. Kuntz, AG 2020, 801, 804 ff. |

| 14 | Eingehend Uwer, ZHR 183 (2019) 154, 156 ff. |

| 15 | Fleischer, ZIP 2003, 1, 9. |

| 16 | Dreher, FS Hopt, 2010, S. 517, 530; zu weiteren Beispielen Seibt, FS Karsten Schmidt, 2009, S. 1463, 1464 ff. |

| 17 | Großzügig BGH v. 5. 10. 1981 – II ZR 203/80, ZIP 1982, 578; trotz eines abweichenden Ausgangspunkts i. Erg. ähnlich Kuntz, AG 2020, 801, 811 ff. |

| 18 | So das Schweizer Schrifttum, hierzu Kuntz, AG 2020, 801, 807; aufgenommen von Fleischer, ZIP 2003, 1. |

| 19 | Möslein, ZIP 2018, 204, 208. |

| 20 | Seibt, FS Karsten Schmidt, 2009, S. 1463, 1475; ähnlich Kuntz, AG 2020, 801, 807 f. |

| 21 | Breit rechtsvergleichend Fleischer, FS Schwark, 2009, S. 137, 149 ff.; außerdem Seibt, FS Karsten Schmidt, 2009, S. 1463; Koch, FS 50 Jahre AktG, 2016, S. 65, 100 ff.; Kuntz, AG 2020, 801, 802 ff.; aus der Praxis bereits Endres, ZHR 163 (1999) 441, 448. |

| 22 | Zur daraus folgenden Verortung individueller Entscheidungen siehe die Graphik unter III. 3.; Andeutungen eines graduellen Verständnisses auch bei Bachmann, WM 2015, 105, 107 ff.; Zetzsche, AG 2019, 1, 7. |

| 23 | Siehe dazu: https://alphafold.com. |

| 24 | Siehe z.B. Logg/Minson/Moore, 151 Organizational Behavior and Human Decision Processes (2019) 90. |

| 25 | Geltend gemacht, aber im Ergebnis offen geblieben in BGH v. 28. 11. 1988 – II ZR 57/88, BGHZ 106, 54; siehe Fleischer, ZIP 2003, 1, 10; Koch, FS 50 Jahre AktG, 2016, S. 65, 92 ff.; zur aktienrechtlichen Unzulässigkeit einer Geschäftsordnungsregelung wonach bei Patt die KI entscheidet Noack, FS Windbichler, 2020, S. 947, 957; diff. ders., ZHR 183 (2019) 105, 136 f. |

| 26 | Dubovitskaya/Buchholz, ZIP 2023, 63, 67 ff.; siehe auch Strohn, ZHR 182 (2018) 371, 373 zum Fragerecht des Aufsichtsrats, der allerdigs den Einsatz nicht erklärbarer KI für zulässig hält, ebda. S. 375. |

| 27 | Siehe beispielsweise Delaware General Corporate Law § 141(e): “information, opinions, reports, or statements presented by any of the corporation's officers, employees, or committees” wird unterschieden von “any other person”; dazu Uebler, 65 The Business Lawyer (2010) 1023; eingehend Fleischer, ZIP 2009, 1397, 1398 ff.; ders., KSzW 2013, 3, 5 f. |

| 28 | Siehe zur Differenzierung im US-amerikanischen Recht: https://www.professorbainbridge.com/professorbainbridgecom/2023/09/does-the-business-judgment-rule-apply-to-a-boards-choice-of-expert.html. |

| 29 | Dreher, FS Hopt, 2010, S. 517, 528 ff. |

| 30 | Siehe insbesondere die (allerdings vereinzelt gebliebenen) Judikate des BGH zur GmbH, in der vermeintlich die Beschaffung aller denkbaren Informationen gefordert wurde: BGH v. 14. 7. 2008 – II ZR 202/07, NZG 2008, 751; BGH v. 18. 6. 2013 – II ZR 86/11, NJW 2013, 3636. |

| 31 | Überblick bei BeckOGK/Fleischer, Stand: 1. 10. 2023, § 93 AktG Rdn. 92 ff.; ders., FS Wiedemann, 2002, S. 827, 840 f.; siehe weiter Bachmann, WM 2015, 105; Schäfer, ZIP 2005, 1253, 1258; Karsten Schmidt/Lutter/Sailer-Coceani, AktG, 4. Aufl. 2020, § 93 Rdn. 17; GroßkommAktG/Hopt/Roth, 5. Aufl. 2015, § 93 Rdn. 108; MünchKommAktG/Spindler (Fn. 9), § 93 Rdn. 59; KölnKommAktG/Cahn, 4. Aufl. 2023, § 93 Rdn. 51; Seyfarth, Vorstandsrecht, 2. Aufl. 2023, § 23 Rdn. 26. |

| 32 | Kay/King, Radical Uncertainty, Decision-making for an unknowable future, 2020, S. 97 ff. |

| 33 | Andeutungen bereits bei Fleischer, FS Schwark, 2009, S. 137, 149 ff.; Koch, FS 50 Jahre AktG, 2016, S. 65, 100 ff.; Seibt, FS Karsten Schmidt, 2009, S. 1463. |

| 34 | Vergleichbarer Ansatz bei Zetzsche, AG 2019, 1, 7. |

| 35 | Zu einer Analogie zu § 33 Abs. 1a WpHG a.F. (jetzt § 80 Abs. 2 WpHG) siehe Möslein, ZIP 2018, 204, 211; ablehnend Dany, BB 2022, 2056, 2058 f.; Hommelhoff/Hopt/Leyens/Spindler/Seidel, Unternehmensführung durch Vorstand und Aufsichtsrat (im Erscheinen), § 13 Rdn. 30 ff.; Zetzsche, AG 2019, 1, 8. |

| 36 | Hierzu Noack, FS Windbichler, 2020, S. 947, 956; ders., ZHR 183 (2019) 105, 122, 131 ff.; Hommelhoff/Hopt/Leyens/Spindler/Seidel (Fn. 35), § 13 Rdn. 14 mit einer Differenzierung zwischen informationsbeschaffender, analysierender und prognostischer KI. |

| 37 | Zur Diskussion um die Frage, ob auch § 91 Abs. 3 AktG die Einrichtung eines Compliance Management Systems verlangt siehe MünchKommAktG/Spindler (Fn. 9), § 91 AktG Rdn. 111 m.w.N. |

| 38 | Etwa Möslein, ZIP 2018, 204, 209; Noack, FS Windbichler, 2020, S. 947, 954 f.; Hommelhoff/Hopt/Leyens/Spindler/Seidel (Fn. 35), § 13 Rdn. 36 ff.; Zetzsche, AG 2019, 1, 8 ff. |

| 39 | Dubovitskaya/Buchholz, ZIP 2023, 63. |

| 40 | Fleischer, NJW 2009, 2337, 2339; ders., ZIP 2009, 1397, 1404. |

| 41 | Siehe Möslein, ZIP 2018, 204, 209 m.w.N. |

| 42 | So auch in Kremer/Langenbucher, VGR-Beiheft 2023 (im Erscheinen). |

| 43 | Dubovitskaya/Buchholz, ZIP 2023, 63, 71 zu “XAI als Lösung” (X steht für explainable, mithin für erklärbare KI). |

| 44 | In diese Richtung auch Noack, FS Windbichler, 2020, S. 947, 954 (“Prüfung auf Folgerichtigkeit”); S. 955 zur Funktion der KI als kritischer Begleiter. |

| 45 | Für die Präferenz menschlicher Akteure für eine “slow and effortful consideration in high stakes scenarios” siehe Burton et al., 33 Journal of Behavioral Decisions Making (2020) 220. |

| 46 | Dubovitskaya/Buchholz, ZIP 2023, 63, 70. |

| 47 |

| 48 | Diese Unterschiede als “unnötig technikavers” einzuordnen (so Linardatos, ZIP 2019, 504, 507; dies aufgreifend Hommelhoff/Hopt/Leyens/Spindler/Seidel (Fn. 35), § 13 Rdn. 25) greift zu kurz. Für den Ruf nach dem Aufbau von Technikbeherrschung siehe Möslein, ZIP 2018, 204, 209; Weber/Kiefner/Jobst, NZG 2018, 1132, 1132; Wagner, BB 2018, 1097, 1100. Dubovitskaya/Buchholz, ZIP 2023, 63, 64, weisen zu Recht darauf hin, dass dieses Verständnis den Vorstand nicht zum “Herr des Verfahrens” macht. Wie weiter oben erörtert verlangt § 76 Abs. 1 AktG aber diese Form der sachlichen Überprüfung gar nicht. Zur Frage, inwieweit sich das Vorgehen der KI von menschlichem Vorgehen im Bereich des Einsatzes in der Medizin unterscheidet: Batache (Fn. 1), S. 151 ff. |

| 49 | Gut verständliches Lehrbuch Russell/Norvig, Artificial Intelligence. A Modern Approach, 4. Aufl. 2021, dort S. 430 ff. (Wahrscheinlichkeiten), S. 669 ff. (maschinelles Lernen). |

| 50 | Hierzu Langenbucher, BKR 2023, 205 m.w.N. |

| 51 | Beispiele bei Langenbucher, SAFE White Paper No. 96/2023 (Fn. |

| 52 | Zur Datengovernance Armour/Eidenmüller, ZHR 183 (2019) 169, 176 ff. Neben der Datenabhängigkeit der Vorhersagen der KI sind weitere Besonderheiten zu bedenken. Die Programmierung menschlichen Erfahrungswissens (prior knowledge) stellt besondere Herausforderungen an die meisten Modelle, so dass aus menschlicher Sicht selbstverständliche Erkenntnisse bei Vorhersagen der KI nicht stets berücksichtigt sind, hierzu Marcus, Deep Learning: A Critical Appraisal, erhältlich unter https://arxiv.org/abs/1801.00631 S. 11 f. Agrawal/Gans/Goldfarb, Prediction Machines, 2018, bezeichnen KI als induction machines. Damit einher geht ein Mangel an anderen Schlussformen. Deduktive Schlüsse erfordern Programmierung und vertragen sich deshalb schlecht mit der selbstlernenden KI, auch abduktive Schlüsse zieht die KI nicht, Überblick m.w.N. bei Langenbucher, SAFE White Paper No. 96/2023 (Fn. |

| 53 | Beispiele bei Agrawal/Gans/Goldfarb (Fn. 52), S. 43 ff., 98 ff.; dies., Power and Prediction, 2022, S. 27 ff. |

| 54 | Siehe auch Strohn, ZHR 182 (2018) 371, 377 “in dem so abgegrenzten Bereich ein nicht beherrschbares Risiko”. |

| 55 | An dieser Stelle berührt sich die Fragestellung mit der Diskussion um die Anforderungen an die Einholung hinreichender Informationen vor einer unternehmerischen Entscheidung. Fleischer, Der Aufsichtsrat 2018, 121 und Möslein, ZIP 2018, 204, 209, gehen davon aus, dass die Befragung einer KI zunehmend als erforderlich begriffen werden wird, unabhängig davon, ob deren Vorhersage erklärbar ist oder nicht. |

| 56 | Zu den Stellungnahmen der BaFin: https://www.bafin.de/SharedDocs/Veroeffentlichungen/DE/BaFinPerspektiven/2019_ 01/bp_ 19–1_Beitrag_SR3.html; https://www.bafin.de/SharedDocs/Veroeffentlichungen/DE/Fachartikel/2023/fa_ bj_ 2305_ Algorithmen_ Kreditvergabe.html; Details in MARisk AT 4. 3. 5., zur Erklärbarkeit dort Nr. 6, abrufbar unter: https://www.bafin.de/SharedDocs/Veroeffentlichungen/DE/Rundschreiben/2023/rs_ 05_ 2023_ MaRisk_ BA.html?nn=19643896#doc19615962bodyText15. |

| 57 | Dazu Langenbucher, BKR 2023, 205 m.w.N.; Noack, FS Windbichler, 2020, S. 947, 950 f.; ders., ZHR 183 (2019), 105, 117; Hommelhoff/Hopt/Leyens/Spindler/Seidel (Fn. 35), § 13 Rdn. 24. |